※ 본 내용은 stanford에서 제공하는 cs231n 강의, 강의자료를 바탕으로 작성하였습니다.

Assignment2 - Q4에서는 convolution layer, pooling layer를 구현하고, 최종적으로 CNN을 구현한다.

추가로 CNN에 특화된 batch normalization layer인 spatial batch normalization layer을 구현하는 내용 또한 다루고 있다.

그 중 convolution layer의 역전파 수식과 spatial batch normalization의 구현에 대해 정리해보겠다.

<Convolution layer의 역전파>

Convolution layer의 역전파 또한 이전과 동일하게 chain rule을 이용해 계산할 수 있다.

X=(x11x12x13x21x22x23x31x32x33),W=(w11w12w21w22),bias=b,

간단하게 3x3 input과 하나의 2x2 filter 간의 convolution 연산을 살펴보겠다. (stride = 1, padding = 0)

위 예시만으로도 convolution 역전파 방식에 대해 파악할 수 있다.

Y=(x11w11+x12w12+x21w21+x22w22+bx12w11+x13w12+x22w21+x23w22+bx21w11+x22w12+x31w21+x32w22+bx22w11+x23w12+x32w21+x33w22+b)

=(y11y12y21y22)

dout=(dLdy11dLdy12dLdy21dLdy22)

위와 같이 연산의 결과는 y, 계산 그래프를 타고 전달되는 역전파의 값은 dout으로 나타냈다.

이제 dLdx21의 계산을 살펴보겠다.

Chain rule에 의해 dLdx21는 다음 수식으로 계산된다.

dLdx21=ΣΣdLdyijdyijdx21

이때 dyijdx21는 yij의 계산에 x21이 포함되지 않은 경우 0, 포함된 경우는 x21과 곱해진 weight 이므로, (y의 수식을 직접 미분)

위 수식을 풀어쓰면 다음과 같이 미분값을 얻을 수 있다.

dLdx21=ΣΣdLdyijdyijdx21=dLdy11∗w21+dLdy12∗0+dLdy21∗w11+dLdy22∗0

즉, dLdx21는 'x21이 영향을 끼친(계산에 포함된) yij의 역전파값(dLdyij)과 그때 x21과 곱해진 weight의 곱의 합'이 된다.

전체 dLdx를 계산하기 위해서는 x21을 xrc로 일반화시키기만 하면 된다.

dLdw를 구하는 과정도 위 과정과 동일하다.

<Spatial Batch Normalization>

CNN에서 batch normalization을 적용하려면 mean과 std를 channel에 대해 계산해야 한다.

channel 별로 통계를 내는 이유는 같은 channel이 같은 weight(filter)의 영향을 받았기 때문이다.

(과제에서 간단하게 소개된 개념이라, 자세한 개념은 실제 spatail batch normalization 논문을 참고하는 것을 추천합니다.)

Batch normalization의 구현도 복잡했기 때문에 구현에 앞서 걱정이 앞섰지만,

주석으로 제공된 hint를 이용하여 비교적 간단하게 구현할 수 있었다.

앞서 구현한 batch normalization을 그대로 이용하면 된다.

다만 적용하기 위해 shape를 바꾸는 과정의 코드가 꽤 복잡했다.

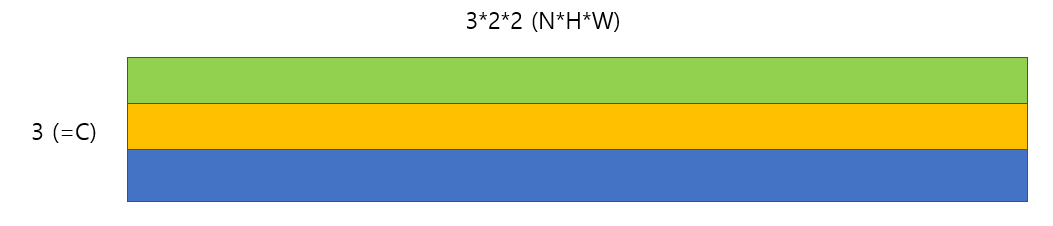

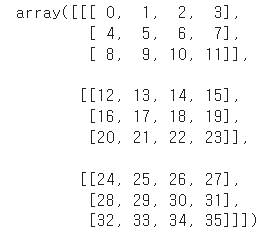

위와 같은 3x3x2x2 (NxCxHxW) 크기의 matrix를 통해 처리 과정을 정리해보겠다.

channel 별로 mean과 std를 구한 후 normalization을 수행해야 하므로,

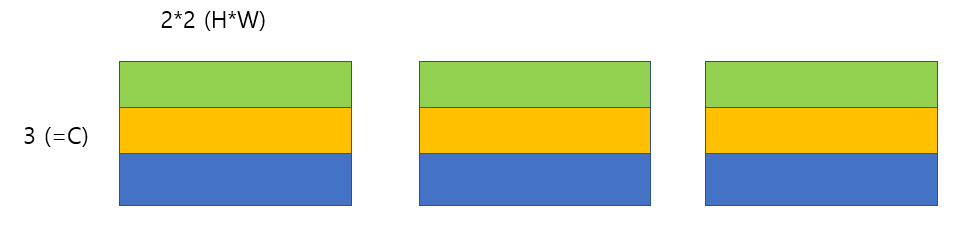

matrix를 다음과 같이 변경해야 한다.

위와 같이 변경하면 각 row별로 일반적인 batch normalzation을 적용하면 된다.

Batch Normarlization 구현 상 row별로 하나의 데이터이므로, 정확히는 위 matrix에 transpose까지 적용해줘야 된다.

그러나 일반적인 reshape 만으로는 위와 같이 변경할 수 없었고,

reshape와 np.concatenate 두 가지 방식을 적용하여 변경이 가능했다.

먼저 reshape이다.

NxCx(H*W)의 형태로 reshape하면 다음과 같이 변경된다.

각 데이터 별로 channel의 matrix는 vector로 reshape되었다. 그림으로 나타내면 다음과 같은 상태이다.

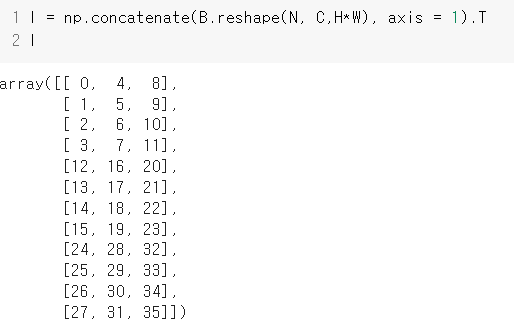

이제 3개의 결과를 row-wise로 이어붙여주기만 하면 되고, 해당 내용은 'np.concatenate( ~, axis = 1)' 코드로 구현이 가능했다.

Concatenate를 수행하고 trasnpose까지 적용한 결과이다.

위 matrix에 대해서는 일반적인 batch normarlization을 적용할 수 있다.

다만 그 결과를 다시 NxCxHxW shape으로 변경시켜주어야 하는데, 해당 내용은 반대의 순서대로 split과 reshape를 적용하면 된다.

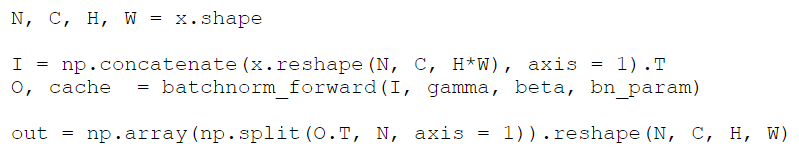

최종 코드이다.

4줄의 코드로 spatial batch normalization의 구현이 가능하다.

Backward 연산의 경우에도 batchnorm_backward가 사용된다는 점을 제외하고 사실상 동일하다.

'Computer Vision > cs231n' 카테고리의 다른 글

| [Lec 12] Visualizing and Understanding (0) | 2022.01.24 |

|---|---|

| [Lec 11] Detection and Segmentation (0) | 2022.01.24 |

| [Assignment 2] Batch Normalization, 역전파 (0) | 2022.01.20 |

| [Lec 10] Recurrent Neural Networks, RNN (0) | 2022.01.19 |

| [Lec 9 ]CNN Architectures (0) | 2022.01.17 |